亦称“最小平方法”。使对因变量的估计值与实际观测值之差的平方达到最小。目前常见的回归分析方法之一,是进行回归分析的基础。又被称作“ordinary least quare”(可译为“普通最小二乘法”或“普通最小平方法”)。这一方法最早由勒让德提出,后经G.F.Guass和P.S.Laplace引入统计学研究之中。下面用一个线性回归模型来具体说明这一方法。

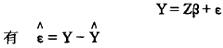

对于回归模型:

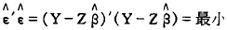

式中,Y是被解释变量向量;Z是解释变量向量;u是白噪声向量;其均值为零,方差为σ2;β是待估参数。最小二乘法要求待估的回归方程使得 的平方和达到最小,即:

的平方和达到最小,即:

因为Y和Z是已知的, 的大小完全取决于

的大小完全取决于 的大小,而

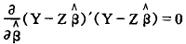

的大小,而 是由估计方法确定的参数。因此,根据微积分中求极值的原理,当

是由估计方法确定的参数。因此,根据微积分中求极值的原理,当 的一阶导数等于零时,

的一阶导数等于零时, 才能达到最小值,因而有:

才能达到最小值,因而有:

整理后有常规方程:

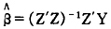

如果(Z’Z)-1存在,以上常规方程有解:

就是回归模型Y=Zβ+ε的普通最小二乘估计值,它使

就是回归模型Y=Zβ+ε的普通最小二乘估计值,它使 达到最小。

达到最小。

由于现实生活中往往出现违背线性回归模型的基本假设,如异方差性、多重共线性、残差自相关等等,以致矩阵(ZZ)近于退化,很难用普通最小二乘法进行模型参数估计。为此出现了基于它的一些更为一般和适用的方法,如广义最小二乘法、加权最小二乘法、间接最小二乘法、工具变量法、约束最小二乘法等等。

- 实用注塑模设计手册是什么意思

- 实用洋烛工艺手册是什么意思

- 实用流体阻力手册是什么意思

- 实用流式细胞分析技术是什么意思

- 实用涂料树脂合成及应用是什么意思

- 实用涂料涂装手册是什么意思

- 实用消化病手册是什么意思

- 实用消毒手册是什么意思

- 实用涉外经济法手册是什么意思

- 实用混凝土结构构造手册是什么意思

- 实用混凝土配合比设计手册是什么意思

- 实用游泳是什么意思

- 实用溶剂手册是什么意思

- 实用演讲辞大全是什么意思

- 实用火柴工艺手册是什么意思

- 实用灯谜大全是什么意思

- 实用灯谜小辞典是什么意思

- 实用热工手册是什么意思

- 实用热物理性质手册是什么意思

- 实用焊接手册是什么意思

- 实用牛羊常见疾病防治手册是什么意思

- 实用物理诊断方法手册是什么意思

- 实用物资价格词典是什么意思

- 实用物资工作手册是什么意思

- 实用物资手册是什么意思

- 实用物资经济辞典是什么意思

- 实用犬病诊疗图册是什么意思

- 实用环境保护数据大全是什么意思

- 实用环境监测水质分析手册是什么意思

- 实用环境科学词典是什么意思

- 实用现代临床医学是什么意思

- 实用现代汉语教程是什么意思

- 实用现代汉语语法是什么意思

- 实用现代经济管理辞典是什么意思

- 实用珠算手册是什么意思

- 实用理疗手册是什么意思

- 实用理论是什么意思

- 实用瓦工手册是什么意思

- 实用生活知识手册是什么意思

- 实用生物学制片手册是什么意思

- 实用生物小词典是什么意思

- 实用电化教育手册是什么意思

- 实用电子公式手册是什么意思

- 实用电子变压器材料器件手册是什么意思

- 实用电子器件和电路简明手册是什么意思

- 实用电子学测试和测量手册是什么意思

- 实用电子电路大全是什么意思

- 实用电子电路手册是什么意思

- 实用电子电路故障查找技术是什么意思

- 实用电子线路集是什么意思

- 实用电工手册是什么意思

- 实用电工技术是什么意思

- 实用电工技术900例是什么意思

- 实用电工技术手册是什么意思

- 实用电工材料手册是什么意思

- 实用电工计算手册是什么意思

- 实用电工速查手册是什么意思

- 实用电教手册是什么意思

- 实用电机修理手册是什么意思

- 实用电气工程安装技术手册是什么意思